Nvidia Triton Inference Server: The Complete Guide for Developers and Engineers

- Por

- Editor

- Idioma

- Inglés

- Formato

- Categoría

No ficción

"Nvidia Triton Inference Server"

Nvidia Triton Inference Server is the definitive guide for deploying and managing AI models in scalable, high-performance production environments. Meticulously structured, this book begins with Triton's architectural foundations, examining its modular design, supported machine learning frameworks, model repository management, and diverse deployment topologies. Readers gain a comprehensive understanding of how Triton fits into the modern AI serving ecosystem, exploring open source development practices and practical insights for integrating Triton into complex infrastructures.

Delving deeper, the book provides an end-to-end treatment of model lifecycle management, configuration, continuous delivery, and failure recovery. It unlocks the power of Triton's APIs—via HTTP, gRPC, and native client SDKs—while detailing sophisticated capabilities like advanced batching, custom middleware, security enforcement, and optimized multi-GPU workflows. Readers benefit from expert coverage of performance engineering, profiling, resource allocation, and SLA-driven production scaling, ensuring robust and efficient AI inference services at any scale.

Triton’s operational excellence is showcased through advanced orchestration with Docker, Kubernetes, and cloud platforms, highlighting strategies for high availability, resource isolation, edge deployments, and real-time observability. The final chapters chart the future of AI serving, from large language models and generative AI to energy-efficient inference and privacy-preserving techniques. With rich examples and best practices, "Nvidia Triton Inference Server" is an authoritative resource for engineers, architects, and technical leaders advancing state-of-the-art AI serving solutions.

© 2025 HiTeX Press (Ebook): 6610001017408

Fecha de lanzamiento

Ebook: 15 de agosto de 2025

Otros también disfrutaron...

- Lo Que Piensas, Lo Creas: El poder invisible de tus palabras, tu mente y tu energía para transformar tu realidad desde adentro Tus Decretos

- Harry Potter y la piedra filosofal J.K. Rowling

- Harry Potter y la cámara secreta J.K. Rowling

- Los secretos de la mente millonaria T. Harv Eker

- Harry Potter y el prisionero de Azkaban J.K. Rowling

- La Sobreviviente Riley Sager

- Harry Potter y la Orden del Fénix J.K. Rowling

- Las muertas Jorge Ibargüengoitia

- Harry Potter y el misterio del príncipe J.K. Rowling

- Por si un día volvemos María Dueñas

- Los siguientes Pedro Simón

- Perras de reserva Dahlia de la Cerda

- Harry Potter y el cáliz de fuego J.K. Rowling

- El Cuervo: Sonido 3D Edgar Alan Poe

- Harry Potter y las Reliquias de la Muerte J.K. Rowling

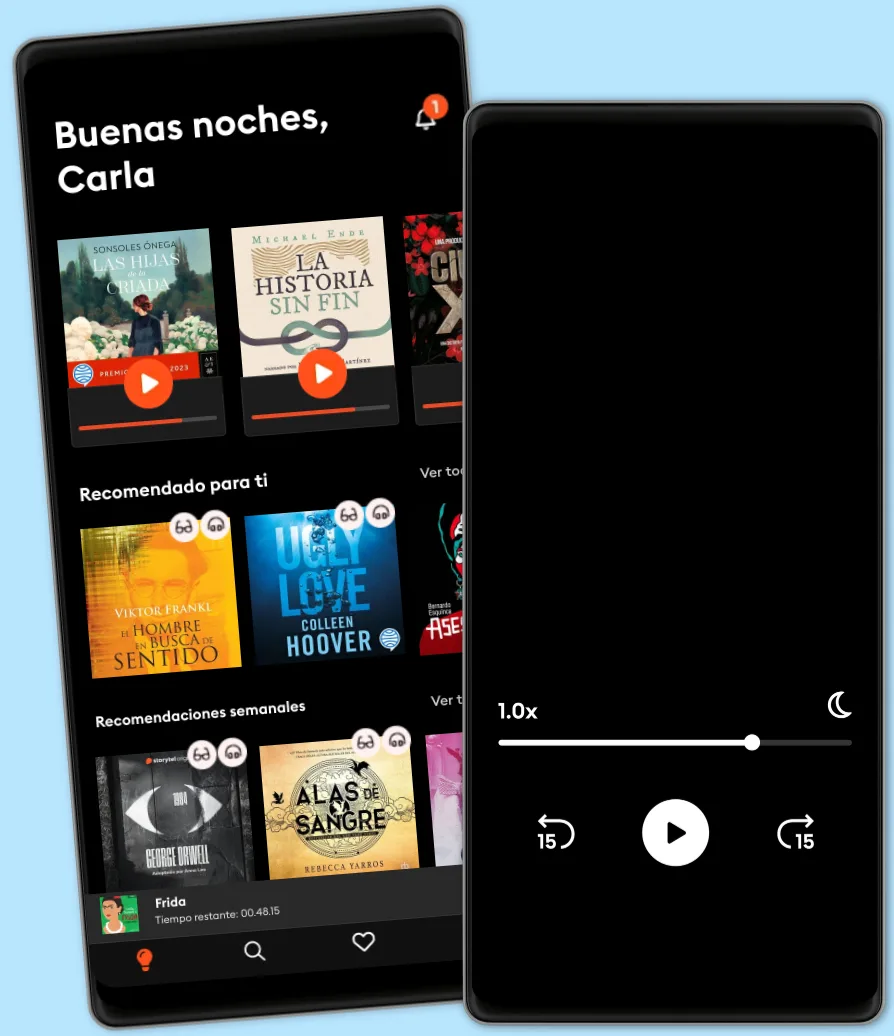

Explora nuevos mundos

Más de 1 millón de títulos

Modo sin conexión

Kids Mode

Cancela en cualquier momento

Ilimitado Mensual

Escucha y lee sin límites.

$169 /mes

Escucha y lee los títulos que quieras

Modo sin conexión + Kids Mode

Cancela en cualquier momento

Ilimitado Anual

Escucha y lee sin límites a un mejor precio.

$1190 /año

Escucha y lee los títulos que quieras

Modo sin conexión + Kids Mode

Cancela en cualquier momento

Familiar

Perfecto para compartir historias con toda la familia.

Desde $259 /mes

Acceso a todo el catálogo

Modo sin conexión + Kids Mode

Cancela en cualquier momento

$259 /mes